Виділіть її та натисніть Ctrl + Enter —

ми виправимo

Штучний інтелект на службі пропаганди

Штучний інтелект (ШІ) розвивається й удосконалюється — і за його допомогою борються з поширенням пропаганди, постправди та дезінформації. Але водночас зацікавлені в поширенні цієї пропаганди також використовують ШІ. За його допомогою популяризують різноманітні теорії змови, втручаються у вибори та виправдовують війни.

Детальніше про те, як ШІ став інструментом пропаганди та дезінформації, у своїй лекції розповів Семюель Вуллі — доцент Школи журналістики та Школи інформації Техаського університету в Остіні (США), який також є керівником проєкту з дослідження пропаганди в Center for Media Engagement. «Детектор медіа» публікує основні тези з лекції Вуллі, організованої Національним демократичним інститутом.

Штучне поширення дезінформації в США

Недавнім, але дуже яскравим прикладом того, як пропаганда використовувала ШІ для автоматизації свого поширення, стали лісові пожежі на Гаваях улітку 2023 року, які забрали життя щонайменше 80 людей. За словами Семюеля Вуллі, відколи в новинах почали транслювати повідомлення про лісові пожежі, в соцмережах почали дуже активно поширювати різноманітні, здавалося б неймовірні, теорії змови.

«Більша частина цього конспірологічного вмісту стверджувала, що розвідувальні служби Сполучених Штатів створили вогонь за допомогою метеорологічної зброї, щоб випробувати її», — розповів він.

Ці повідомлення прямо звинувачували розвідку США в тому, що нібито вона проводила якийсь невдалий експеримент із, хай як дивно це звучить, «метеорологічною зброєю» — але щось пішло не так і вона спровокувала це природне лихо.

На перший погляд здається, що в цю маячню ніхто не повірить. Але ж ні, ці повідомлення траплялися користувачам соцмереж на очі так часто і в таких неймовірних інтерпретаціях, що люди починали в це вірити, самі підхоплювали, інтерпретували й поширювали далі.

«Повідомлення про це поширювали спочатку кількома мовами та кількома соціальними мережами. Але вони так швидко розійшлися, що вже незабаром були перекладені 30 мовами в десяти соцмережах із мільйонами кліків і переглядів», — продовжив дослідник.

Це можна порівняти з кампанією, коли люди масово вірили в теорії змови навколо 5G та COVID-19. Проте маніпулятивні повідомлення про лісові пожежі мали ще одну особливість — крім неймовірної інформації вони містили згенеровані за допомогою ШІ зображення. Вони були моторошно реалістичними та, здавалося, демонстрували докази того, що уряд США був справді причетний до пожеж. Але дослідницька група Microsoft у The Propaganda Lab уважно вивчила ці зображення та помітила дещо дивне. Першим прикладом було зображення статуї Свободи, — вона мала більш ніж п’ять пальців на одній руці. Відтак дослідники Microsoft почали глибше вивчати ці зображення й повідомлення та виявили, що це була операція впливу, пов’язана з Китаєм. Вона містила величезну кількість створених ШІ зображень, які мали дуже високий рівень залучення в соціальних мережах.

У всіх цих кампаніях впливу поширювачі пропаганди частково використовують ботів, частково алгоритми ШІ, за допомогою яких соцмережі помилково вважають повідомлення цікавим і ще більше сприяють його поширенню, а частково — звичайних людей, які через брак медіаграмотності починають вірити в цей маніпулятивний контент, інтерпретують його та поширюють далі.

Семюель Вуллі називає це головним викликом, пов’язаним із ШІ: «Кібербезпека та національна безпека в Сполучених Штатах давно підозрювали, що вороги використовуватимуть генеративний ШІ, щоб зробити дезінформаційні кампанії більш правдоподібними. Це викликає занепокоєння для таких науковців, як я, які протягом останніх кількох років кажуть, що більшість кампаній, які ми бачимо з точки зору пропаганди, часто досягають мети, тому що вони спрямовані на маніпулювання алгоритмами. ШІ стає доступнішим, його використання стає дешевшим і такі держави, як Китай, починають інвестувати в його використання для пропаганди. Афілійовані з Китаєм операції впливу досягають більших результатів у соціальних мережах, оскільки вони покладаються і на ШІ, і на реальних людей для створення індивідуального автентичного контенту».

Кампанія з пожежами — далеко не перший приклад подібних маніпуляцій масовою свідомістю у США. Схожі методи використовувала Росія, коли намагалася вплинути на президентські вибори 2016 року. Тоді члени російського Агентства інтернет-досліджень, що належало Євгенію Пригожину, намагалися проникнути в різні спільноти у Сполучених Штатах — лівих, правих, білих, афроамериканців — і поширювати штучно адаптований пропагандистський контент під конкретні соціальні групи.

«Подібні випадки відбуваються по всьому світу вже давно, зокрема й у Сполучених Штатах ще у 2010 році, коли армії ботів використовували для дезінформаційних кампаній проти сенаторів. Які в підсумку програли свої перегони через неправдиві заяви про те, що вони начебто виступають проти релігії або проти певної соціальної групи. Сьогодні ми спостерігаємо перехід від цих незграбних знеособлених ботів до більш цілеспрямованих зусиль, спрямованих на конкретну аудиторію, які здійснюються на набагато ширшому спектрі платформ», — каже Вуллі.

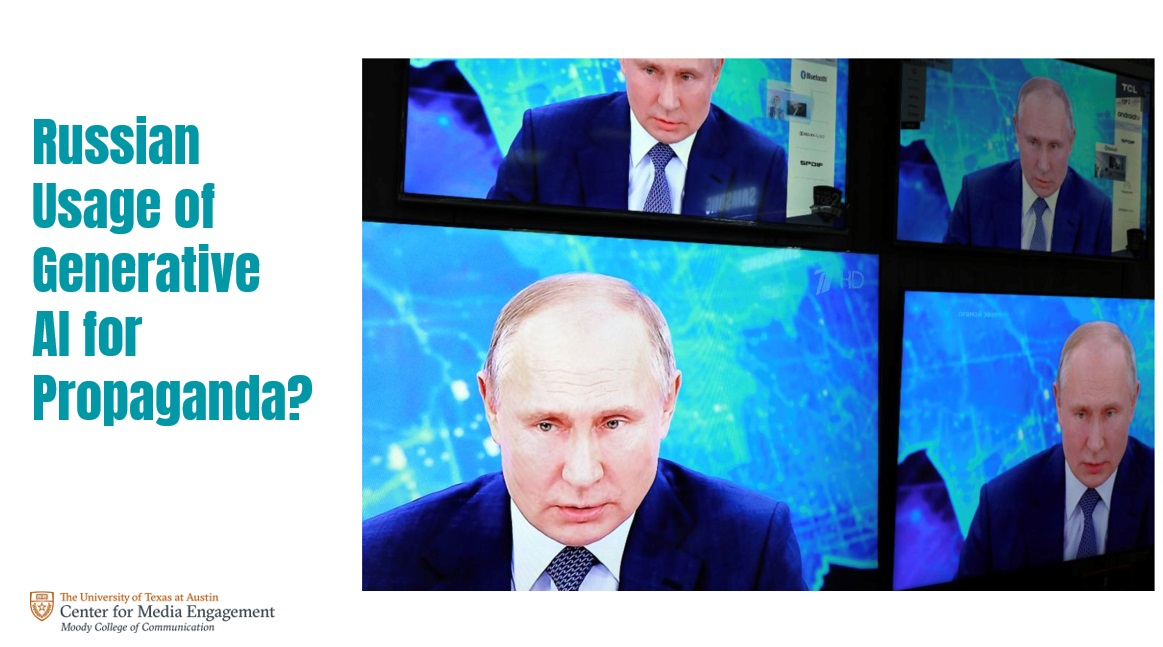

ШІ як інструмент агресора

Якщо повернутися до історії з маніпуляціями навколо лісових пожеж на Гаваях, сказав Семюель Вуллі, варто згадати про ще більш неймовірний приклад — їх у своїй пропаганді використовувала й Росія, зумівши приплести сюди війну в Україні. «Російський уряд також поширював неправдивий контент про гавайські лісові пожежі. У цих повідомленнях ішлося, що уряд США не приділяє належної уваги своєму народу та не розв’язує його проблем, а натомість він приділяє занадто багато уваги Україні, дає занадто багато грошей Україні, хоча повинен зосередитися на своєму власному народові», — розповів він.

Ці абсурдні повідомлення також генерувалися ШІ та поширювалися на конкретні групи за його допомогою. Відтак ШІ з усіма своїми плюсами для людства стає інструментом агресора. Це можна порівняти з ядерною зброєю, яка, з одного боку, є інструментом стримування, але з іншого — активно використовується Росією чи Іраном для залякування своїх суперників. Тобто російська влада зрозуміла, що ШІ дозволив автоматизувати поширення дезінформації, поставивши його фактично на конвеєр. Саме тому, наводить іще один приклад дослідник, нещодавно російський диктатор Володимир Путін говорив про необхідність вдосконалення взаємодії зі ШІ.

Про те, що за найгіршого сценарію ШІ може повністю перетворитися на інструмент для зловмисників на кшталт Путіна, у березні 2023 року говорив науковець Джефрі Хінтон, якого називають «хрещеним батьком штучного інтелекту» — його тоді цитувала російська служба BBC.

«Питання в тому, наскільки охоче та як швидко Росія прийме цю технологію», — каже Семюель Вуллі.

Але очевидно, що практики використання ШІ для поширення своєї дезінформації, зокрема і проти України, Росія, за його словами, використовує вже не перший рік. Наприклад, за інформацією з доповіді одного з американських аналітичних центрів, що займається європейською політикою, росіяни за допомогою ШІ активно поширювали відео з російським лідером ультраправих і українофобом Володимиром Жириновським, де він говорив, що Росія врятує Україну від нацистів. І це було задовго до повномасштабного вторгнення Росії на територію України. Відео з Жириновським, за словами Семюеля Вуллі, — це перший відомий приклад, коли Росія почала використовувати ШІ для поширення дезінформації проти України. Надалі вона робила це в багатьох інших своїх дезінформаційних кампаніях, таким чином готуючи підґрунтя для вторгнення.

Автоматизоване поширення пропаганди як новий виклик для світу

Пропаганда існує сотні років. Відколи виникло суспільство, люди намагаються маніпулювати громадською думкою, використовуючи механізми, відмінні від логіки, використовуючи емоції.

«Ми виявили за останні кілька десятиліть, що пропаганда, яку ми бачимо зараз під час війни в Україні, під час президентських виборів у Сполучених Штатах, під час кризових ситуацій у всьому світі, не схожа на все, що ми бачили раніше. За змістом вона дуже схожа на те, що ми бачили під час холодної війни та навіть сотні років тому. Але методи її поширення змінилися. Все частіше дезінформація посилюється і проштовхується на рівнях, яких ми ніколи не бачили раніше, вона здатна досягати людей набагато швидше», — розповідає Вуллі.

Лабораторія досліджень пропаганди Техаського університету в Остіні, яку він очолює, вивчає способи й технології поширення пропагандистського вмісту в соціальних мережах, включаючи тікток, а також старіших — інстаграм, фейсбук, твітер (або Х), та на ютубі. Крім того, вони вивчають зашифровані чатдодатки вотсап, сигнал і телеграм, які також активно використовуються для політичних маніпуляцій.

«Для вивчення зашифрованих чатдодатків ми використовуємо етнографію, проводимо час у громадах, беремо інтерв’ю у людей, розмовляємо з членами ферм тролів, з урядовцями, журналістами по всьому світу, членами громадянського суспільства та людьми, які стають об’єктами подібного роду нападок. Ми поєднуємо це з обчислювальними дослідженнями в галузі соціальних наук і маємо величезну кількість даних. Ми займаємося порівняльною міжнародною роботою, тому, на відміну від багатьох наших колег, ми не зосереджуємося лише на США, а й на Росії, Єгипті чи Камбоджі — країнах, які відступають від демократії. Я завжди казав, що якщо ви хочете зрозуміти, куди йде пропаганда в Сполучених Штатах, подивіться на Україну», — говорить Семюель Вуллі.

Поширення дезінформації зараз, із розвитком ШІ, за його словами, все більше автоматизується. Як контекстна реклама в інтернеті потрапляє до тих, на кого, найімовірніше, вона вплине, так і маніпулятивні повідомлення конкретного змісту потрапляють саме до потрібної в цей момент соціальної групи, й це можливо завдяки вмілому використанню алгоритмів ШІ.

Ми часто можемо спостерігати, як справді хороші та змістовні дописи в соцмережах, написані справжніми людьми, і близько не набирають такої популярності, як щось маніпулятивне, жорстоке або таке, в яке, здавалося б, нормальна людина не повірить. Річ у тім, що пропаганда створює такий шум і хаос, що не просто активно поширюється сама — вона ще й приглушує справжні автентичні повідомлення.

«Одночасно з тим, як кампанії посилюють програмні повідомлення, збивають людей із пантелику підробленими ШІ зображеннями, відео чи текстом, вони придушують справжній автентичний контент, що надходить від людей. І в міру того, як команди модерації контенту та команди довіри й безпеки соціальних мереж масово скорочуються, що відбувалося протягом останнього року, ми бачимо зростання кількості такого контенту, який є неавтентичним», — розповів американський науковець.

Зараз, після придбання Ілоном Маском компанії X (колишньої Twitter), каже Вуллі, а також через політичний тиск у Сполучених Штатах та інших країнах, боти в цій соцмережі стали агресивнішими, ніж будь-коли, а рівень дезінформації зашкалює. До того ж нещодавно Х звільнила частину команди з питань чесності виборів, а перед тим у соцмережі прибрали функцію, яка дозволяла користувачам поскаржитися на дезінформацію про вибори.

Одночасно з тим, як компанії, що володіють соцмережами, скорочують команди модерації контенту, пропаганда все активніше використовує ботів. Вони створюють ілюзію популярності контенту, який в іншому випадку ніколи б не набув популярності, й виглядає так, ніби багато людей підхоплюють цей контент, поширюють його та вірять у нього. А його вмілому поширенню, як уже було сказано, сприяють технології ШІ.

«Генеративний ШІ може бути використаний для доповнення або повної заміни цих сотень реальних людей — дописувачів соцмереж, зменшуючи кількість працівників, необхідних для роботи кіберфронту та ферм тролів, але значно збільшуючи їхній вплив і зусилля. Якщо витрати знизяться, ми побачимо, що все більше політичних гравців продовжуватимуть спонсорувати й проводити подібні операції з впливу ШІ з меншим штатом співробітників», — продовжив науковець.

Маніпулятивні повідомлення, згенеровані ШІ, вдосконалилися настільки, що їх усе важче відрізнити від справжніх. Науковці з чотирьох університетів, за словами Семюеля Вуллі, у 2020 році провели експеримент — вони, використовуючи ШІ, писали листи від імені низки різних організацій і надсилали їх законодавцям, урядовцям, державним службовцям у Сенаті та Палаті представників. Дослідження показало, що законодавці лише на 2% рідше відповідали на листи, згенеровані ШІ, ніж на листи, написані реальними людьми. Тож існує ризик, що ці мовні моделі можуть бути використані для зловживань і можуть перевантажити системи, якщо це комусь буде потрібно. На думку дослідників, це може підірвати демократію, адже обрані посадовці й інші особи намагатимуться зрозуміти справжні погляди виборців, але будуть таким чином введені в оману.

Цей випадок є прикладом того, що зацікавлені в дезінформації за допомогою ШІ можуть повністю автоматизувати як її генерування, так і її поширення. І саме це, за словами дослідника, є головною небезпекою, яку несе ця технологія, і головним викликом технічного прогресу. Бо зло завжди має перевагу — воно грає не за правилами.