Deepfake наступает: какие угрозы и возможности несет технология, созданная нейросетью

Виділіть її та натисніть Ctrl + Enter —

ми виправимo

Deepfake наступает: какие угрозы и возможности несет технология, созданная нейросетью

MediaSapiens ранее рассказывал о технологии глубинных фейков в статье и в объяснительном видеоролике. Технология и дальше развивается, появляются новые дипфейки. С ней пытаются бороться транснациональные корпорации Facebook, Twitter, Google и отдельные государства – ведь глубинные фейки подрывают правду и угрожают демократии. При этом новшество несет не только угрозы, но и новые возможности. Какие именно – рассказываем в этом материале.

Что такое deepfake?

В 2014 году студент Стэнфордского университета Ян Гудфеллоу разработал технологию, которая стала совершенно беспрецедентным явлением, — deepfake. Дословно deepfake переводится как «глубинная подделка» или «глубинный фейк». Суть в том, что нейросеть — то есть, искуственный интеллект — создает фейковые видео с настоящими людьми.

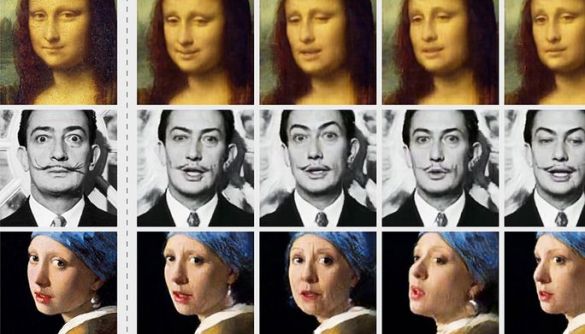

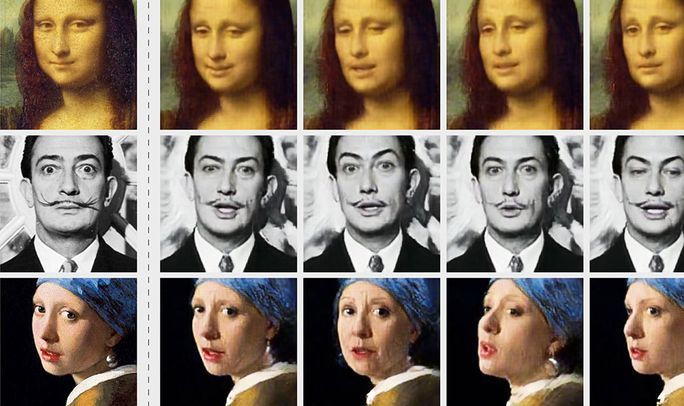

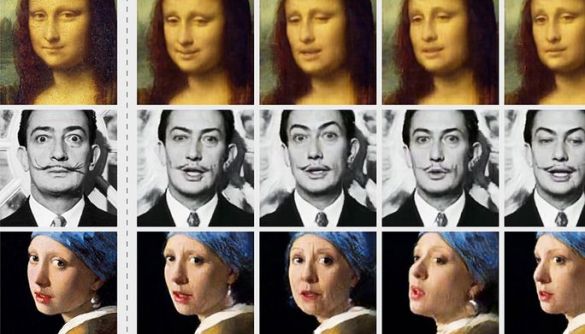

Алгоритм синтезирует данные: фотографии, видео с изображением конкретного человека, анализирует, как этот человек мог бы двигаться, жестикулировать, как он говорит. А затем генерирует новый контент с этим персонажем. Поэтому еще одно название этой технологии — face swapping, то есть, «замена лица». На выходе мы получаем, на первый взгляд, совершенно реальную видеозапись, на которой человек что-то делает и говорит. Вот только при детальном анализе выясняется, что это видео — подделка.

Так, получается, что дипфейк можно использовать для создания поддельных заявлений якобы от лица реальных людей. Эта технология может использоваться и для дискредитации конкретной личности: видео, на котором политик ругается матом, появляется пьяный или делает непристойные вещи, невозможно будет сразу отличить от оригинала.

Дипфейк позволяет «перенести» лицо одного человека на голову другого — по сути, «пересадить» его, таким образом, создавая поддельный контент, который пугает своей реалистичностью.

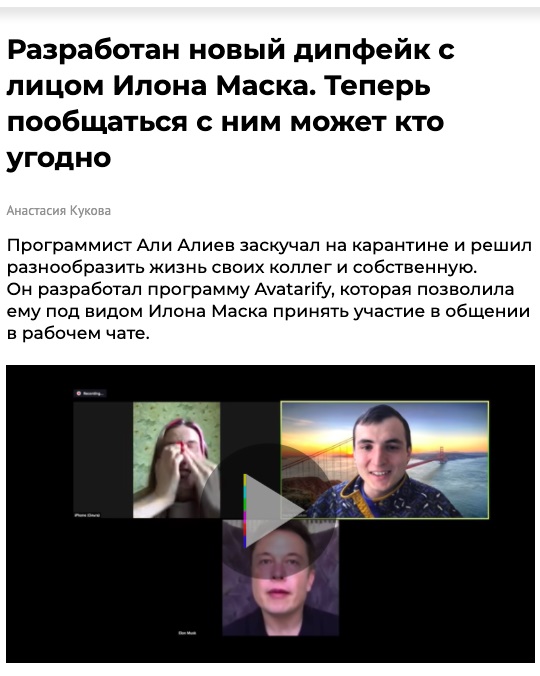

Так, к примеру, сидя на карантине из-за эпидемии коронавируса, российский программист Али Алиев создал дипфейк с лицом Илона Маска и подключился к рабочей встрече в Zoom. Его коллеги на секунду даже поверили, что к ним в онлайн-встречу по ошибке заглянул настоящий Маск.

Для чего это может использоваться

До появления дипфейка единственным возможным способом виртуально «воскресить» мертвых была голограмма. На сцене уже появлялись и голограммы американского рэппера Тупака Шакура, Майкла Джексона и Уитни Хьюстон. В 2012 году в Санкт-Петербурге выступала голограмма Виктора Цоя, в 2018 году голограмма лидера группы «Король и Шут» Алексея Горшенева спела песню на концерте группы. Всех этих артистов уже нет в живых.

Сегодня оживить людей можно с помощью дипфейка. В мае 2019 года в музее американского города Сант-Питерсберг, Флорида, создали выставку к 115-летию со дня рождения художника Сальвадора Дали. С помощью технологии дипфейка виртуальная копия Дали приветствовала посетителей музея, общалась с ними, разговаривая с акцентом, характерным для настоящего Дали, и даже делала селфи на собственный смартфон.

Алгоритмы используют и для того, чтобы человек на видео смог легко и убедительно «заговорить» на любом языке мира. Этим уже воспользовался, к примеру, футболист Дэвид Бэкхем, который снялся в социальной рекламе кампании по борьбе с малярией и обратился к аудитории на девяти разных языках.

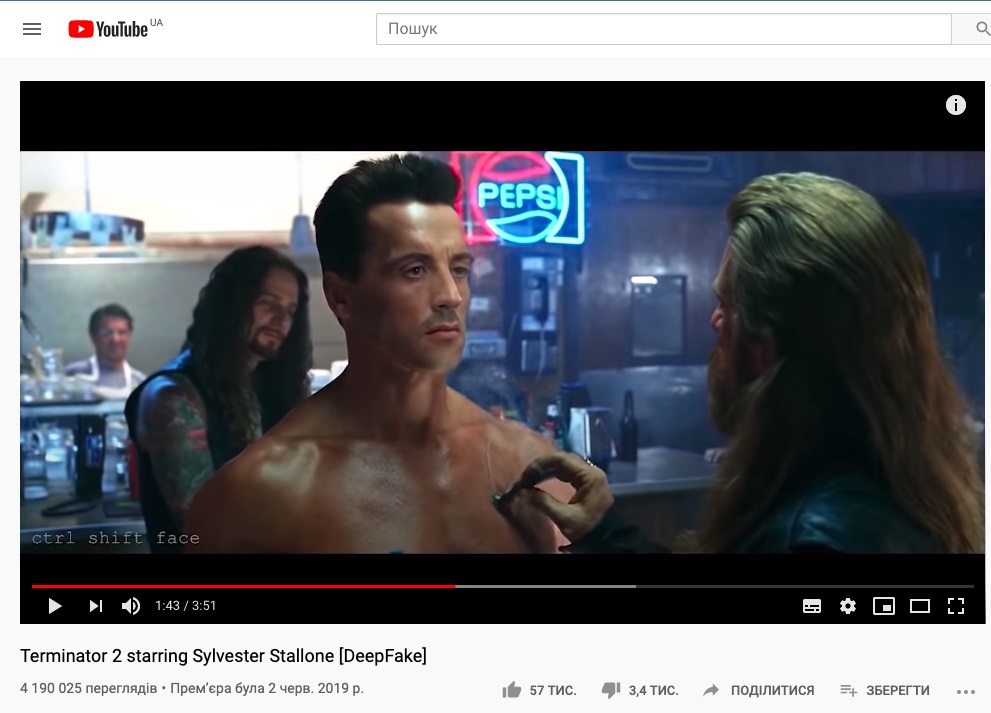

Ради эксперимента с помощью нейросетей создают «гибридов». В фильм «Терминатор-2», например, вместо Арнольда Шварцнеггера «подселили» Сильвестра Сталлоне.

А в этом эпизоде из «Кавказской пленницы» вместо знаменитой троицы — Вицына, Никулина и Моргунова — «играют» Аль Пачино, Арнольд Шварцнеггер и Шон Пэн. А в этом — в «Иронии судьбы» появляется Одри Хепберн.

Технологию вполне можно использовать для омоложения или состаривания актеров в кино. Этот прием могли бы использовать создатели сериала «Ирландец» от Netflix, однако они омолодили своих актеров с помощью компьютерных технологий, потратив на это большие деньги.

Одной из основных сфер применения технологии является порноиндустрия. Дипфейк позволяет создать порно с участием любого человека — начиная вашим соседом или вами самими и заканчивая президентом любой из стран. Спрос рождает предложение, и вот в сети уже появились отдельные сайты с порнографическим контентом, который создал дипфейк.

В такой неловкий конфликт уже попали политики Малайзии: в сети обнаружилось видео, на котором местный министр экономики занимается сексом с другим малазийским политиком. В этой мусульманской стране гей-секс — под запретом.

Жертвы deepfake

Жертвами дипфейка уже стали известные топ-политики, например, действующий президент США Дональд Трамп и его предшественник, Барак Обама. Правда, Обаму в этом видео «подделали» с научной целью исследователи технологии:

В сети также появилось видео с фейковыми заявлениями основателя Facebook Марка Цукерберга, который рассуждает: тот, кто контролирует данные, контролирует и будущее. Намекая, конечно же, на себя самого.

В Туркменистане настоящий фурор вызвало дипфейк-видео с президентом страны Гурбангулы Бердымухамедовым, на котором он рассказал, как якобы развлекается в выходные дни: моет свое авто и планирует поехать с друзьями в сауну. На данный момент видео уже не доступно для просмотра из-за жалоб.

Дипфейк может воспроизводить не только изображение, но и голос — отдельно. Последней жертвой искуственного интеллекта стал рэппер Jay-Z: в интернете появилось видео, на котором он зачитывает строки из Шекспира. На самом деле, артист такого ролика не записывал. Рэппер обратился в YouTube с жалобами и попросил удалить этот контент. Его и правда удалили, но после — восстановили.

Казалось бы, это всего лишь стихи — безобидная шутка. Однако вместо Шекспира можно было использовать что угодно: опорочить артиста скандальным заявлением, шокирующим признанием или клеветой.

Победить deepfake

Способа, который позволил бы защититься от дипфейка, нет. Фактически, любой, кто разбирается в работе нейросетей, может взять изображения и видео кого угодно, «собрать» из них собственное видео и использовать в любых целях. Зрителю, который мало знаком с техническими нюансами, распознать дипфейк может быть довольно нелегко. Хотя некоторые ролики, конечно, могут быть сделаны топорно: если присмотреться, видно, что рот человека двигается не совсем правильно, как бы не попадая в речь, в некоторых местах может быть видна «склейка»: место, куда «пришили» чужое лицо.

На данный момент сложно предугадать, каким будет будущее дипфейка. Когда-нибудь такая технология вполне сможет заменить реальных людей: телеведущих, музыкантов и, конечно же, порноактеров. Вероятно, что дипфейк и дальше будут использовать для создания политического, агитационного контента, а также для дискредитации отдельно взятых личностей.

Возможно, когда-нибудь эта технология даже превратится в инструмент массового использования и станет такой же доступной, как маски в Instagram: просто наводишь камеру на свое лицо, выбираешь «маску», начинаешь говорить, и вот, на готовом видео вместо тебя уже «толкает речь» принцесса Диана, Элвис Пресли или Иосиф Сталин.

Иллюстрация - everest.ua