«Штучний інтелект Facebook поки не вирішує проблему трансляції терактів» — вчений

«Штучний інтелект Facebook поки не вирішує проблему трансляції терактів» — вчений

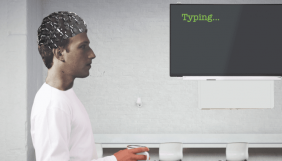

Зіткнувшись з важкими питаннями про те, як Facebook буде видаляти терористичний контент, гендиректор компанії Марк Цукерберг пропонує просту відповідь: це робитиме штучний інтелект. Але, за словами керівника лабораторії штучного інтелекту Facebook Яна ЛеКуна, має пройти ще багато років до того, аби така модерація запрацювала в повній мірі, особливо коли йдеться про перегляд відео у реальному часі.

Про це провідний науковець розповів на виставці лабораторії штучного інтелекту у Парижі, інформує Bloomberg News. Він повідомив, що Facebook знаходиться «за багато років» до використання штучного інтелекту для до модерування живого відео глобально, пише видання.

«Ця проблема дуже далека від вирішення», — сказав ЛеКун, який нещодавно був нагороджений премією Тьюрінга, відомої як своєрідна «Нобелівська премія» для науковців, які займаються обчислювальною технікою.

Приводом для переосмислення принципів трансляції прямих ефірів у Фейсбуці стали терористичні акти у мечетях міста Крайстерч, Нова Зеландія. 15 березня 28-річний бойовик разом зі спільниками вбив 51 людину у мечеті міста Крайстчерч (Нова Зеландія), транслюючи теракт у прямому ефірі на Facebook.

Хоча у Facebook цю трансляцію подивилося, як стверджують у компанії, не більше 200 людей, пізніше люди все ж могли завантажити відео і ділитися ним із іншими.

За словами провідного науковця, такі відео штучний інтелект ідентифікує далеко не завжди. Автоматизовані системи дуже ефективно видаляють контент, який вже був визначений людьми як небажаний, але сам виявляє його складніше.

Однією з проблем, яку ЛеКун окреслив у Парижі, є відсутність навчальних даних для покращення роботи штучного інтелекту.

«На щастя, у нас немає багато прикладів реальних людей, які стріляють в інших», — сказав вчений. За його словами, можна «навчити» системи визначати насильство за допомогою фільмів, але тоді контент, що містить «штучне» насильство, буде випадково видалено разом із справжнім.

Натомість у компанії Facebook зосереджують увагу на використанні автоматизованих систем у якості помічників для працівників-модераторів. Штучний інтелект позначає небезпечний контент «прапорцями», і тоді люди вручну перевіряють його.

Нагадаємо, раніше ми писали про те, що у Facebook змінюють правила прямих ефірів через трансляцію терактів.