Технологію діпфейк використали у прокитайській дезінформаційній кампанії

Технологію діпфейк використали у прокитайській дезінформаційній кампанії

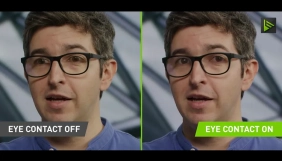

Наприкінці 2022 року дослідницька фірма Graphika, яка вивчає дезінформацію, виявила в мережі кампанію із просування інтересів Китаю та послаблення авторитету США. Кампанія була орієнтована на англомовну аудиторію та включала зокрема використання технології діпфейк. Про це пише The New York Times.

У соцмережах прокитайські облікові записи ботів поширювали відеозаписи, на яких начебто ведучі новинного видання під назвою Wolf News промовляли підозрілі тексти на кшталт того, що Сполученим Штатам має бути соромно за брак рішучих дій проти насилля, а роль Китаю у міжнародних відносинах стає все більш важливою. За оцінками експертів Graphika, це був перший випадок, коли технологія діпфейк була використана у рамках державної інформаційної кампанії.

Попри те, що технологія діпфейк розвивається протягом останніх десяти років, сфера її застосування все ще не є чітко врегульованою законами. Саме тому експерти з дезінформації давно попереджали, що відео, створені із використанням діпфейк, можуть вводити в оману людей і маніпулювати із їхньою здатністю розрізняти в інтернеті реальність від підробок.

Останніми тижнями, як ідеться у публікації NYT, в інтернеті було виявлено ще одне відео з використанням подібної технології штучного інтелекту, на якому зображення людей, створені за допомогою діпфейк, називали себе американцями. Вони закликали посилити підтримку уряду Буркіна-Фасо, який наразі підозрюють у зв’язках із Росією.

Онлайн-інструменти, за допомогою яких можна створити діпфейк будь-якої особи і використати для поширення дезінформації, є досить доступними. Graphika пов’язала виникнення двох фейкових ведучих Wolf News із технологією, створеною британською компанією під назвою Synthesia, офіс якої розташований у Лондоні.

Як повідомляється, Synthesia — заснований п’ять років тому стартап, який розробляє програмне забезпечення для створення діпфейкових аватарів. Клієнту просто потрібно написати сценарій, який потім читає один із цифрових «акторів», які створені за допомогою інструментів Synthesia.

За словами Synthesia, аватари зі штучним інтелектом — це «цифрові близнюки», їхня зовнішність відтворює зовнішній вигляд найнятих акторів. Аватарами можна керувати, зокрема можна запрограмувати мову, якою вони спілкуватимуться, стать, вік, етнічне походження, тембр голосу та естетичні вподобання.

В базі аватарів Synthesia є зокрема персонаж зі штучним інтелектом на ім’я Джордж. Він справляє враження досвідченого бізнесмена, має сиве волосся і носить костюми. Інший аватар, Гелія, носить хіджаб. Карло ходить у касці, Семюел — у білому медичному халаті. Клієнти також можуть використовувати Synthesia для створення власних аватарів на основі себе чи інших осіб, які надали їм дозвіл.

Програмне забезпечення Synthesia, яке коштує лише 30 доларів на місяць, допомагає створювати діпфейкове відео за лічені хвилини. Увесь процес «так само простий, як написати електронний лист», повідомляє Synthesia на своєму вебсайті.

Віктор Ріпарбеллі, співзасновник і виконавчий директор Synthesia, заявив, що ті, хто використовував їхню технологію для створення аватарів, виявлених Graphika, порушили умови обслуговування. У цих умовах зазначено, що технології компанії не можна використовувати для «політичного, сексуального, особистого, кримінального та дискримінаційного контенту». Втім, Ріпарбеллі відмовився поділитися інформацією про тих, хто стоїть за створенням відео із «ведучими Wolf News», але сказав, що їхні облікові записи призупинено.

Фото: Mface Ai / Facebook