Як штучний інтелект може вплинути на виборців — експеримент Channel 4

Як штучний інтелект може вплинути на виборців — експеримент Channel 4

Щоб з’ясувати, наскільки великою загрозою є штучний інтелект та створені за його участю фейкові матеріали, британський телеканал Channel 4 вирішив провести унікальний експеримент. Протягом двох тижнів журналісти їздили до містечка Саутенд-он-Сі на узбережжі Ессекса, щоб вибрати 12 домогосподарств різного віку та походження, але з однією об’єднуючою характеристикою: усі вони були виборцями, які не визначилися.

Про журналістське практичне дослідження пише видання The Telegraph.

«Наша місія полягала в тому, щоб використати суміш реальних політичних повідомлень разом із фейковими матеріалами, створеними штучним інтелектом, глибокими фейками та загальною дезінформацією, щоб «підштовхнути» їх голосувати тим чи іншим способом», — розповіли автори експерименту.

Учасники були розділені на дві групи по шість осіб: шістьом домогосподарствам показували підроблений контент, щоб схилити їх до голосування за Лейбористську партію, а іншим шістьом демонстрували підроблений вміст, щоб схилити їх до голосування за Консервативну партію.

Ніхто з них не здогадувався, що побачить створений штучним інтелектом або глибоко фейковий матеріал – вони вважали, що експеримент покликаний спостерігати за реакцією на різноманітні політичні матеріали.

‘It blew my mind’@c4dispatches and @cathynewman, led a unique political experiment where they tested whether AI manipulated messaging could influence a group of undecided voters, as the UK gets ready for a General Election. pic.twitter.com/H7P4j8K13P

— Channel 4 Dispatches (@C4Dispatches) June 27, 2024

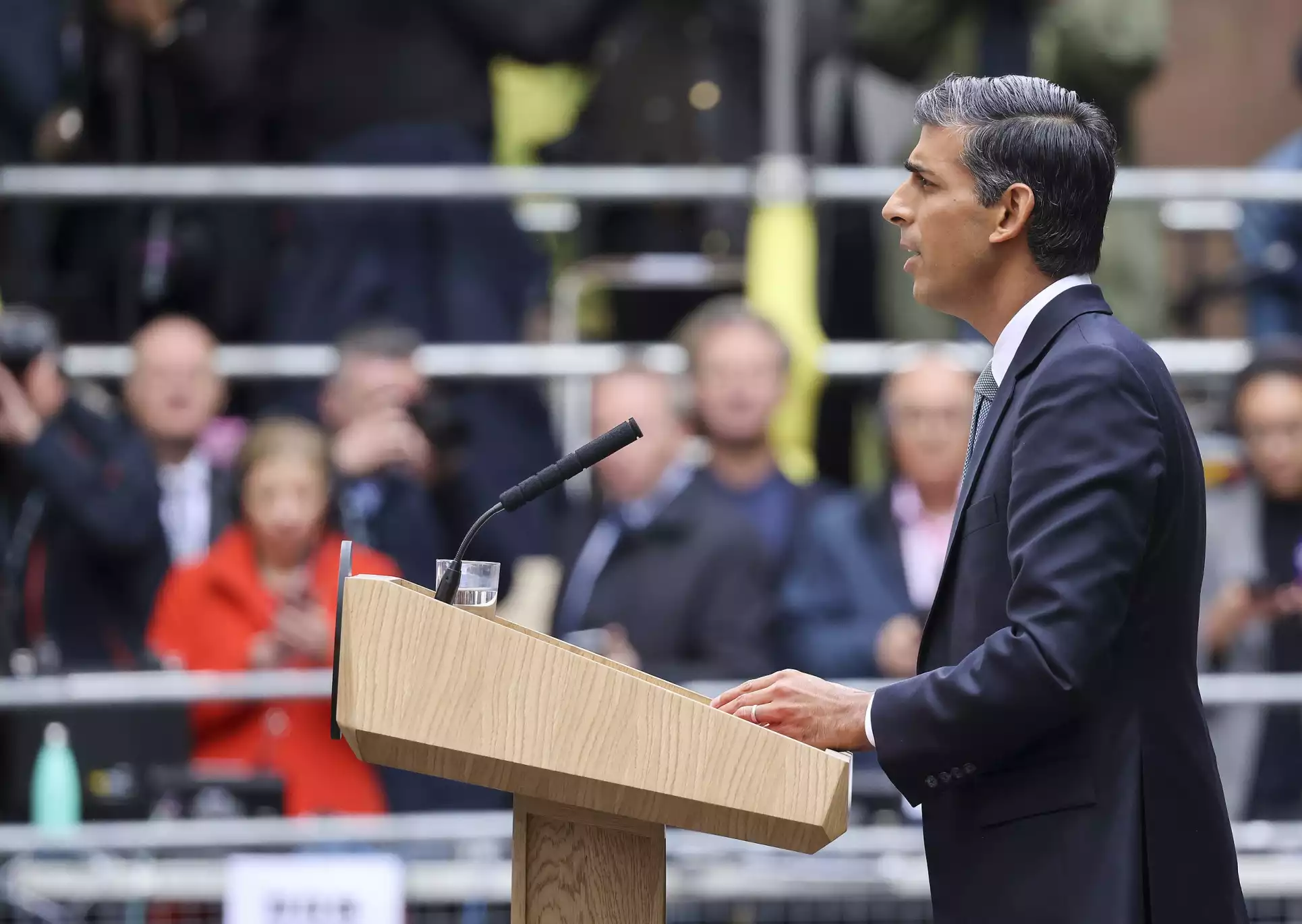

Використовуючи генеративний штучний інтелект — технологію, яку можна «навчити» створювати новий контент — журналісти створили серію відео, у яких справжнього прем’єр-міністра Великої Британії Ріші Сунака та лідера Лейбористської партії Кейра Стармера замінили на версії, згенеровані штучним інтелектом.

У цих роликах, фейковий Ріші Сунак оголосив про нібито нову політику стягнення 35 фунтів стерлінгів за прийом до лікаря загальної практики. Так само лідер Лейбористів оголосив фальшиву обіцянку поставити шукачів притулку на перше місце в списку для отримання соціального житла.

«Як і всі старанні політичні стратеги, ми з’ясували, що спонукало наших «виборців», а потім взялися за мікротаргетування за допомогою контенту, який міг би відповідати їхнім інтересам та ідеології. Люсі дбала про житло. Для Мони це була спочатку економіка, а потім державні послуги; для Шані — освіта. І Тереза переживала про імміграцію. Ми знали, які кнопки натискати», — розповідають журналісти.

Також журналісти залучили актора Стівена Фрая, який дозволив використовувати ШІ, щоб маніпулювати тим, що він говорить. Експеримент тривав упродовж двох тижнів.

Після завершення експерименту настав час попросити людей зробити вибір, а потім розповісти їм, як ними маніпулювали. Цікаво, що майже всі учасники проголосували відповідно до упередженості, зображеної у відео.

«Це є нагадуванням про легкість, з якою зловмисники, ворожі держави чи просто суперницька сторона можуть, якщо ми їм дозволимо, здійснювати контроль, перевертаючи демократію з ніг на голову. І на всіх нас лежить тягар зупинитися й подумати, перш ніж довіряти тому, що ми бачимо в Інтернеті», — підсумували в матеріали журналісти.

Переглянути експеримент Channel 4 можна за посиланням.

Фото: Уряд Великої Британії.